Также подобный результат показывает, что высока вероятность наличия ошибок технического характера или же дело в самом контенте. Особенно часто проблема дублирования встречается на сайтах электронной коммерции. Речь идёт краулинговый бюджет о страницах сортировки, фильтрации, внутреннем поиске и т.п.

Настройте Карту Сайта Sitemapxml

- Любая поисковая система старается оптимизировать процесс индексации сайтов, выделяя на каждый из них лимиты.

- Однако даже у них есть определенные ограничения в количестве страниц, которые поисковые роботы посещают ежедневно.

- Ещё один важный источник информации об ошибках – это инструменты вебмастеров.

- На относительно маленьком проекте о краулинговом бюджете можно не задумываться, т.к.

- А что касается просто похожих страниц, то для решения этой проблемы, прочитайте статью про канибализацию ключевых запросов.

Можно ли повлиять на поисковые системы, чтобы увеличить это число? Ниже мы рассмотрим основные средства оптимизации лимита обхода страниц сайта поисковыми роботами. Если вы владеете небольшим сайтом или оптимизируете его, то причин для беспокойства нет. Но если у вас крупный проект, то оптимизация краулингового бюджета жизненно необходима, поскольку окажет влияние на ранжирование сайта в поисковых системах.

Эти файлы играют ключевую роль в корректном индексировании вашего сайта поисковиками. С их помощью поисковые роботы формируют иерархию ресурса и анализируют структуру контента. Однако ситуация кардинально меняется, если на ресурсе публикуется большое количество новых страниц и бюджета не хватает на то, чтобы краулер их обошел. В итоге скорость попадания документов в индекс замедляется, а сайт теряет потенциальных посетителей. Именно поэтому, если владельцы ресурса занимаются web optimization продвижением и хотят видеть сайт в ТОПе, то они должны озаботиться оптимизацией краулингового бюджета. Карта — это файл, содержащий список подстраниц данного веб-сайта вместе с его обновлениями и модификациями.

Некачественные ресурсы, имеющие небольшое количество страниц и редко обновляемые, проверяются не так часто, как более информативные и полезные для пользователей сайты. Однако даже у них есть определенные ограничения в количестве страниц, которые поисковые роботы посещают ежедневно. Низкий краулинговый бюджет может оказаться проблемой для владельцев сайтов, ведь он напрямую влияет на эффективность продвижения. Краулинговый бюджет является критическим ресурсом для успешной индексации, особенно для крупных веб-проектов.

Не надо так делать, потому что это также может плохо повлиять и на краулинговый бюджет. Далеко не каждая CMS позволяет создавать карту сайта в соответствии с вашими планами, и туда может попасть много мусора. Хуже того, некоторые CMS вообще не умеют такие карты сайта создавать.

Еще одна проблема, которая может замедлить частоту сканирования веб-сайта, связана с наличием слишком большого числа редиректов. Подобно дублированному контенту, еще один фактор, который может повлиять на бюджет сканирования, — это тонкие страницы контента. Это очень распространенная проблема на страницах категорий электронной коммерции, где похожие продукты могут быть перечислены в нескольких категориях. Это означает, что к путь к любой страницы сайт, должен быть не более чем в трех кликах от главной страницы сайта. В этом руководстве вы узнаете простым языком, что такое бюджет сканирования (и связанные с ним термины, а также то, как это влияет на web optimization https://deveducation.com/ и какие действия вы можете предпринять для оптимизации. Индексация заключается в добавлении страницы в базу данных поисковой системы, благодаря чему у нее появится шанс появиться в результатах поиска.

Равномерное и постепенное сканирование страниц позволяет минимизировать нагрузку на сервер. Когда поисковые роботы заходят на новую или обновлённую страницу, они должны отсканировать весь контент от кода до картинок и отправить его в индекс. Во время своей работы, они нагружают сервер, на котором размещён сайт. В нормальных условиях количество страниц для сканирования должно постоянно увеличиваться (при условии, что вы регулярно добавляете новый контент на сайт). Если вы не вносите никаких изменений, шаблон должен быть похожим, если вы сравниваете два периода времени.

Первое, с чего начинается технический аудит сайта – это проверка перенаправлений на главную страницу. Страница может быть доступна по HTTP или HTTPS, а также с WWW и без него. Это дубли, и в таком случае поисковая система может счесть главным зеркалом любую из этих версий, а вы потеряете контроль – и краулинговый бюджет. Поэтому в обязательном порядке нужно настраивать 301-й (постоянный) редирект на выбранную вами версию. В динамике можно увидеть, на какое количество страниц робот заходит каждый день — это косвенно укажет на краулинговый бюджет сайта. Когда робот Google обнаруживает редирект 301, он может не сканировать перенаправленный URL-адрес сразу, а добавит в список URL-адресов для сканирования.

Сегодня, вследствие ракетных ударов, каждый из нас столкнулся с ежедневными отключениями или тревогой из-за возможных отключений электроэнергии. Эти два типа ошибок напрямую относятся к проработке внутренней перелинковки и становятся причиной проблем с краулингом и индексацией. Для глобальных же изменений начните с семантики и группировки запросов.

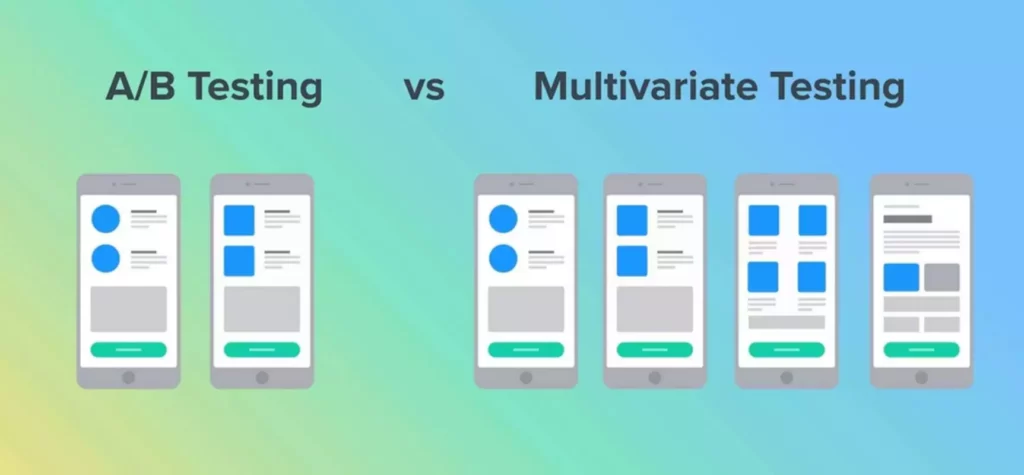

Сайт необходимо наполнять Ручное тестирование актуальным и качественным контентом, обновлять старые статьи и информацию, добавлять хороший визуал. Поисковики замечают такие ресурсы и вознаграждают, например, дополнительным краулинговым бюджетом. И это логично — информативный и актуальный сайт заслуживает внимания пользователей. Поисковые системы далеко не сразу вносят в свои базы данных новые страницы сайтов.

Оптимизация Краулингового Бюджета

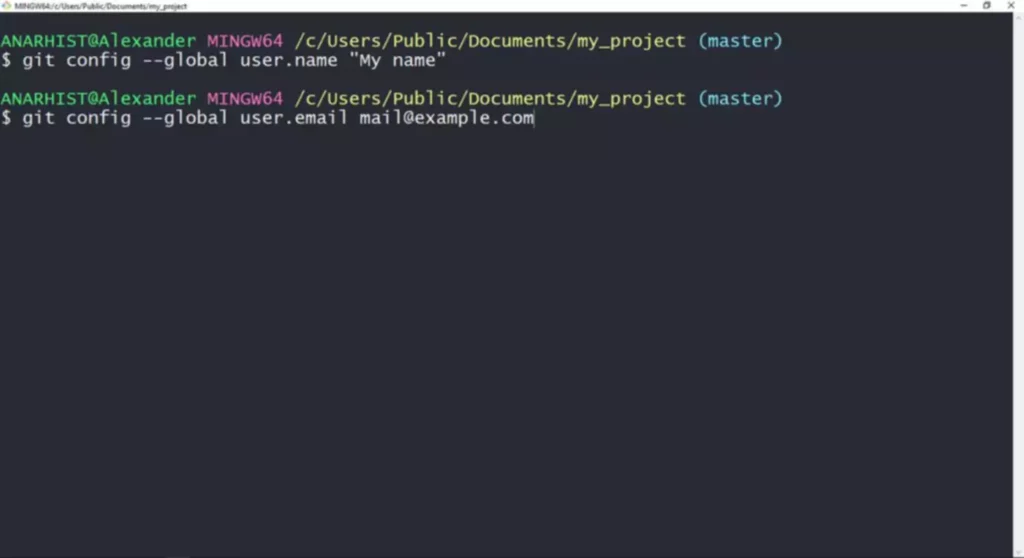

Если в команде есть разработчик, можно попросить его настроить выгрузку отчётов логов сервера. newlineЭто поможет узнать, на какие страницы робот заходил, а на какие — нет, какие взял в индекс, а какие — нет. Необходимо посмотреть, сколько страниц сайта за сутки обходят роботы Яндекс и Google. Сделать это можно в Яндекс.Вебмастер и Google Searсh Console.

Краулинговый бюджет позволяет распределять вычислительную мощность роботов. Чем лучше оптимизация страницы, тем больше она интересует Google. В противном случае он не будет тратить на это время и займется другим сайтом. Эффективная балансировка нагрузки достигается путем настройки правил распределения трафика с учетом пиковых часов активности поисковых роботов и выделения для них отдельных серверных ресурсов. Интеграция CDN-сетей должна учитывать географическое распределение поисковых дата-центров для минимизации латентности. Регулярный мониторинг серверных метрик, включая использование CPU, RAM и пропускной способности сети, позволяет поддерживать оптимальную производительность системы для эффективного сканирования.

Документы, которые имеют большое количество внешних ссылок (с других ресурсов), могут чаще посещаться краулерами. Поэтому, путем грамотного распределения внешней ссылочной массы, можно управлять поведением поисковых ботов. Такое явление встречается в некоторых CMS системах, когда одна и та же страница доступна по разным URL-адресам. В последующем произойдет их склейка, и поисковик сам определит какая из страниц будет в выдаче, но в момент индексации на каждую из них тратятся лимиты.

Избавьтесь От Ошибок

Ссылки, приводящие к несуществующим страницам или документам, в результате чего может выскакивать ошибка 404, способны отпугнуть пользователей. Вместе с тем они негативно влияют на поведенческие факторы и мешают нормальной работе поисковых ботов. Ссылки на не существующие страницы (с кодом ответа 404) могут увеличить процент отказов и негативно влиять на поведенческие факторы, мешая работе поисковых ботов.